2025-12-15 05:49:06 PM

4 phút đọcXuất bản: 2025-06-29 10:39 PM

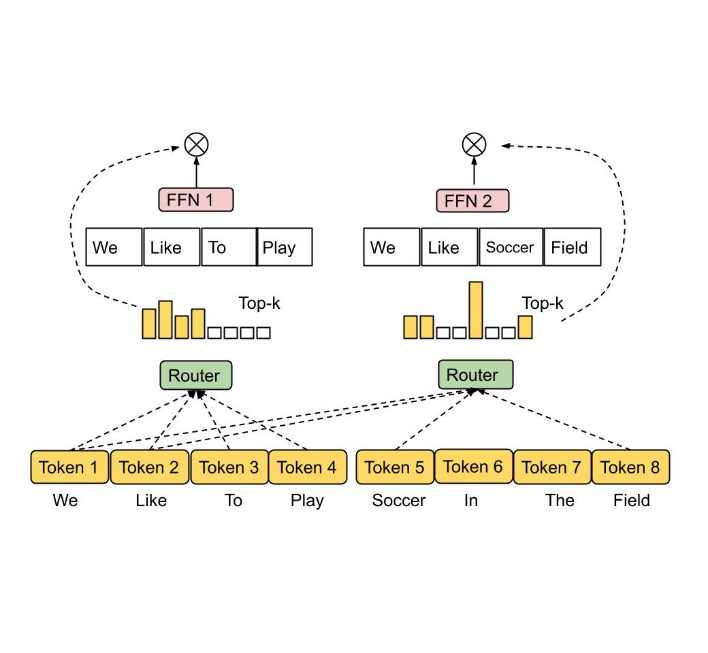

Mixture-of-Experts là gì? Cấu Trúc Đột Phá Đằng Sau Các Mô Hình AI Khổng Lồ Như GPT, Mixtral, Gemini

Mixture-of-Experts là gì? Đây là kiến trúc nền tảng đột phá giúp các mô hình AI quy mô lớn như GPT, Mixtral, Gemini vận hành hiệu quả hơn bao giờ hết. Bài viết sẽ giải thích chi tiết nguyên lý hoạt động của Mixture-of-Experts (MoE), từ lịch sử hình thành, cơ chế routing thông minh, đến lợi ích thực tiễn trong việc xử lý ngôn ngữ tự nhiên, mã hóa và trí tuệ nhân tạo. Dưới góc nhìn của Developer, bài viết đi sâu vào các phép toán nội bộ của MoE layer, giúp bạn hiểu rõ cách hoạt động của gating network, top-k routing và tích hợp các chuyên gia độc lập (expert) để tăng hiệu suất tính toán nhưng tiết kiệm tài nguyên. Đây là cẩm nang lý tưởng nếu bạn đang học về LLMs, AI systems hoặc hạ tầng kiến trúc AI hiện đại.

Mixture-of-Experts là gìMoE là gìMixture of Expertkiến trúc MoEmô hình GPT sử dụng MoEgating network là gìchuyên gia trong AItop-k routingexpert layer transformermixtral moehiệu ứng router moemô hình hỗn hợp chuyên giamodel phân chia chuyên mônkiến trúc chia để trị AImiutre of expretmixure of expertmóe trong AIcấu trúc MoE transformer